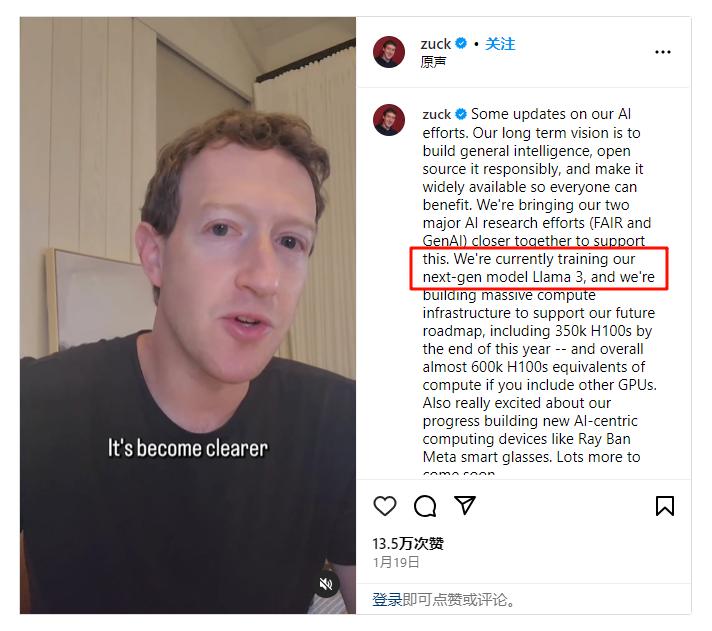

Llama 3性能炸裂,Meta要用“开源”争夺大模型王座

Llama 3性能炸裂,Meta要用“开源”争夺大模型王座如果说 OpenAI 已经占据了今天闭源大模型生态的一极,那 Meta 无疑是代表开源大模型的另一极。

如果说 OpenAI 已经占据了今天闭源大模型生态的一极,那 Meta 无疑是代表开源大模型的另一极。

Google 最近在大模型上动作不断,先是发布了性能更强大的多模态 Gemini 1.5 Pro,然后是开源的小模型 Gemma,评测结果超过了 7b 量级的 Llama 2。

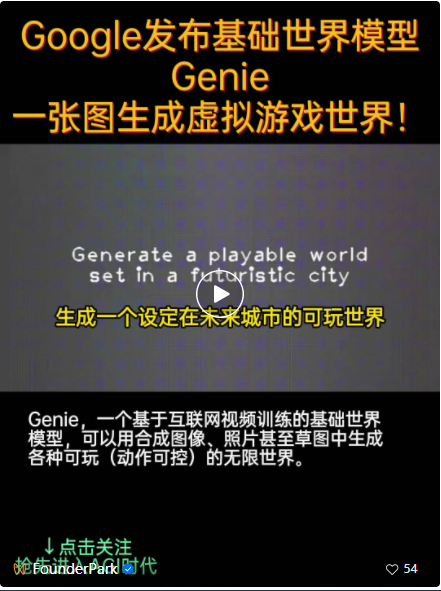

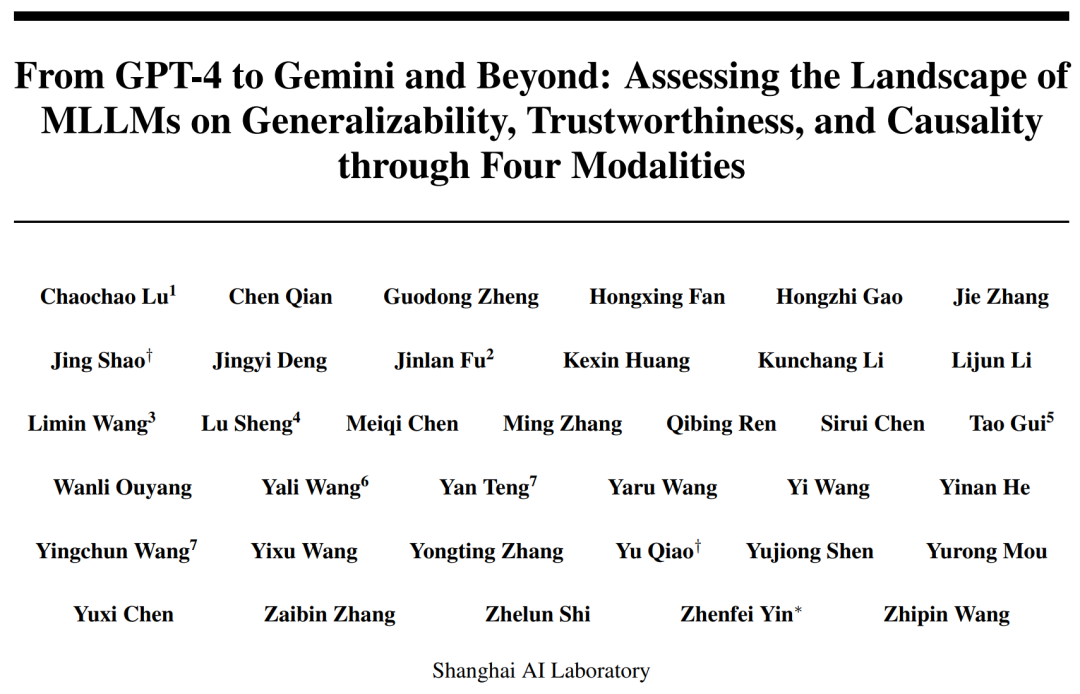

2023 年我们正见证着多模态大模型的跨越式发展,多模态大语言模型(MLLM)已经在文本、代码、图像、视频等多模态内容处理方面表现出了空前的能力,成为技术新浪潮。以 Llama 2,Mixtral 为代表的大语言模型(LLM),以 GPT-4、Gemini、LLaVA 为代表的多模态大语言模型跨越式发展。

LLaMa 3 正寻找安全与可用性的新平衡点。

成功从过去的经验中提取知识并将其应用于未来的挑战,这是人类进化之路上重要的里程碑。那么在人工智能时代,AI 智能体是否也可以做到同样的事情呢?

2023 年 12 月,首个开源 MoE 大模型 Mixtral 8×7B 发布,在多种基准测试中,其表现近乎超越了 GPT-3.5 和 LLaMA 2 70B,而推理开销仅相当于 12B 左右的稠密模型。为进一步提升模型性能,稠密 LLM 常由于其参数规模急剧扩张而面临严峻的训练成本。

在 AI 赛道中,与动辄上千亿参数的模型相比,最近,小模型开始受到大家的青睐。比如法国 AI 初创公司发布的 Mistral-7B 模型,其在每个基准测试中,都优于 Llama 2 13B,并且在代码、数学和推理方面也优于 LLaMA 1 34B。

Meta 正式发布 Code Llama 70B,这是 Code Llama 系列有史以来最大、性能最好的型号。

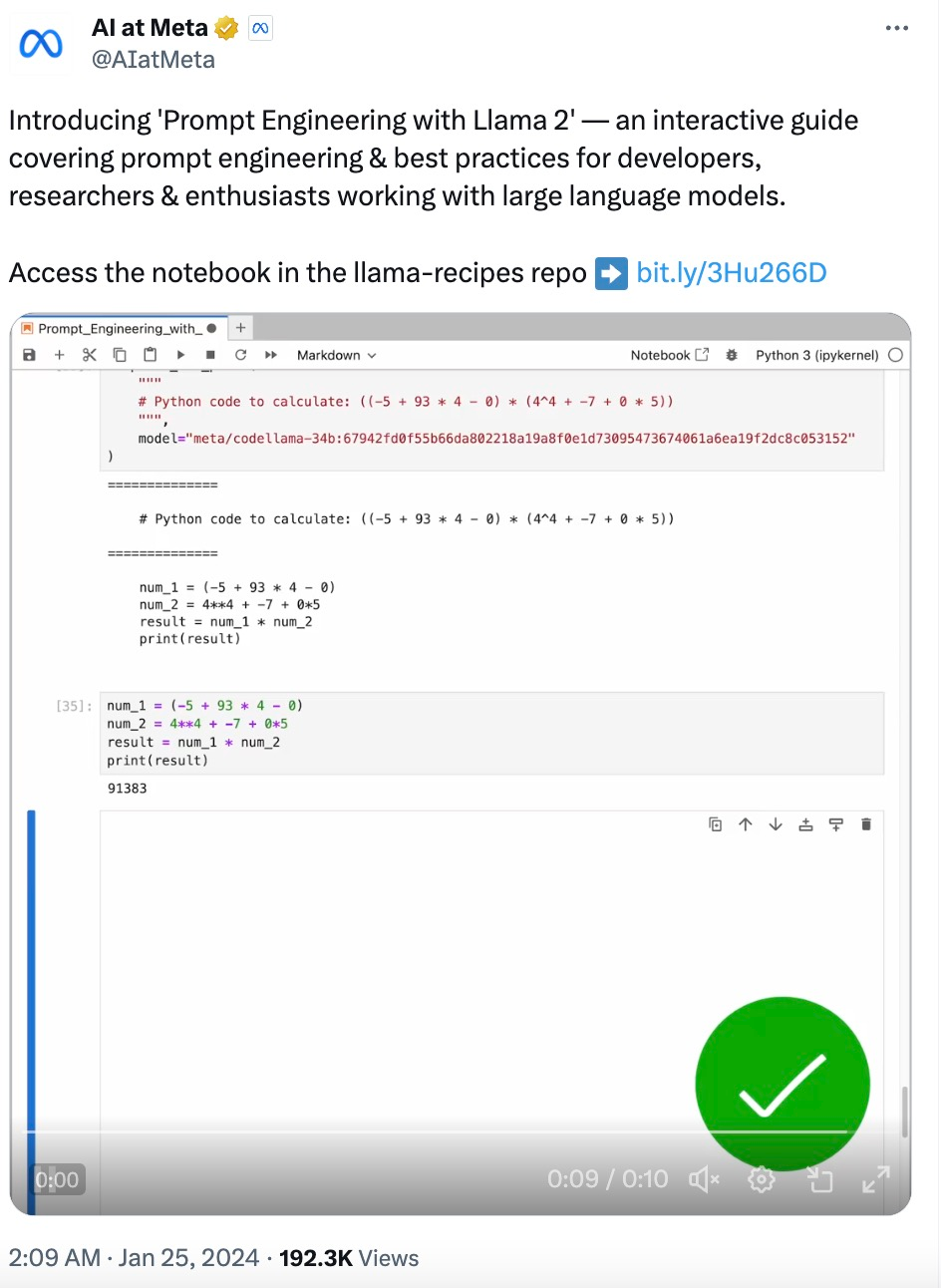

随着大型语言模型(LLM)技术日渐成熟,提示工程(Prompt Engineering)变得越来越重要。一些研究机构发布了 LLM 提示工程指南,包括微软、OpenAI 等等。

AI训AI必将成为一大趋势。Meta和NYU团队提出让大模型「自我奖励」的方法,让Llama2一举击败GPT-4 0613、Claude 2、Gemini Pro领先模型。